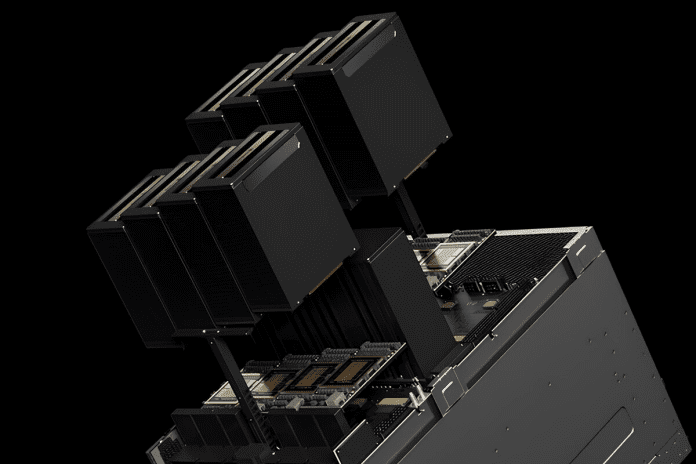

- Según DeepSeek la infraestructura utilizada para entrenar este modelo de IA contiene 2.048 chips H800 de NVIDIA

- Algunos analistas defienden que su hardware aglutina 50.000 GPU H100 compradas a través de intermediarios

Es la noticia del día. Y, quizá, de la semana. El modelo de inteligencia artificial (IA) chino de código abierto DeepSeek R1 está provocando un terremoto en las tecnológicas estadounidenses. Y lo está haciendo debido a su naturaleza abierta. No obstante, su modelo de negocio no es lo único que representa una amenaza para las empresas de IA y semiconductores de EEUU. Lo más sorprendente es que la infraestructura que sostiene DeepSeek es relativamente modesta.

Para entender con cierta precisión de qué estamos hablando nos interesa recordar que la GPU para IA que se está utilizando actualmente con más frecuencia en los centros de datos es el chip H100 de NVIDIA. La compañía liderada por Jensen Huang ya está entregando las primeras unidades de su sucesora, la plataforma B200, que, como cabe esperar, sobre el papel es todavía más potente. Sin embargo, las sanciones aprobadas por el Gobierno de EEUU impiden a NVIDIA vender a sus clientes chinos estas GPU. Aquí reside en gran medida la capacidad rupturista de DeepSeek

La eficiencia de DeepSeek y su naturaleza abierta están convulsionando Silicon Valley

A las empresas chinas que se dedican a desarrollar y entrenar modelos de IA no les ha quedado otra opción que agudizar el ingenio. Sabemos que muchas de ellas siguen comprando las GPU más avanzadas de NVIDIA a través de intermediarios y en mercados paralelos, pero posiblemente no lo están haciendo en las cantidades que necesitan. Si nos ceñimos a DeepSeek según Financial Times la infraestructura utilizada para entrenar este modelo aglutina 2.048 chips H800 de NVIDIA. Y el entrenamiento con 671.000 millones de parámetros ha costado 5,6 millones de dólares.

Fuente Xataka